Материалы по тегу: pci express

|

04.04.2024 [22:34], Александр Бенедичук

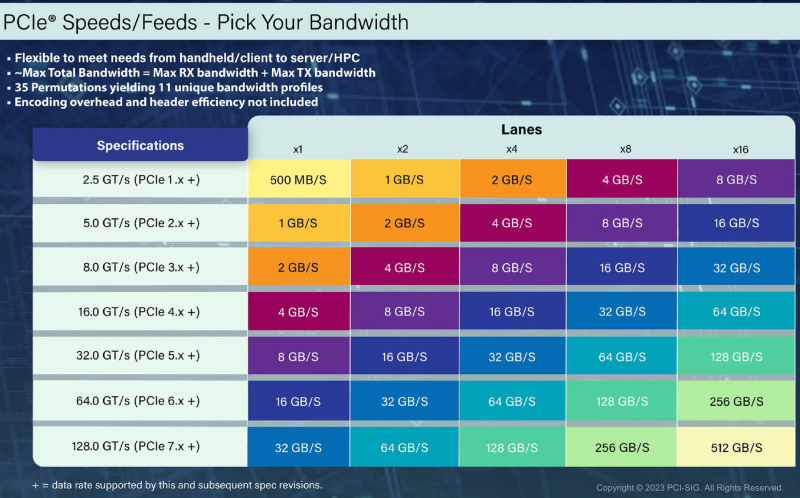

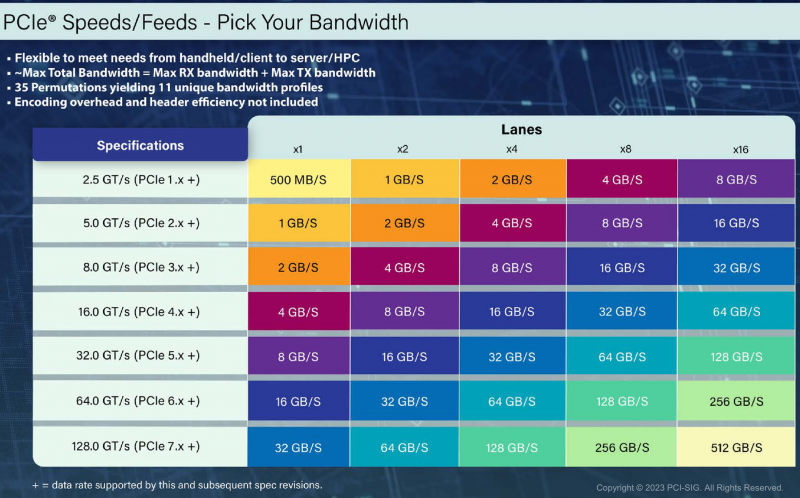

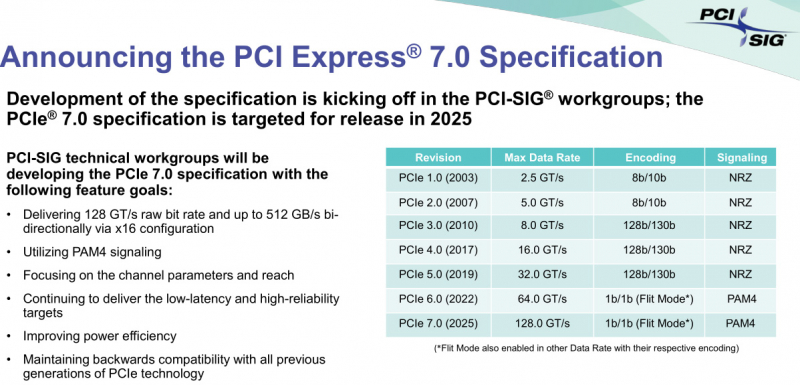

Полстандарта: опубликована спецификация PCIe 7.0 версии 0.5Организация PCI-SIG опубликовала первую полную предварительную версию спецификаций грядущего стандарта PCI Express 7.0. Таким образом, будущий интерфейс, который удвоит пропускную способность по сравнению с PCIe 6.0, стал на шаг ближе к воплощению в реальных продуктах. В блоге президента PCI-SIG Эла Янеса ( Al Yanes) говорится: «Продолжается работа над спецификацией PCI Express (PCIe) 7.0, которую PCI-SIG анонсировала на конференции разработчиков в США в июне 2022 года. Благодаря напряженной работе наших технических групп, мы рады сообщить, что версия 0.5 теперь доступна для ознакомления. Это официальный первый вариант спецификации, учитывающий все отзывы, которые мы получили от пользователей после выхода версии 0.3 в июне 2023 года». Янес говорит, что PCIe 7.0 ориентирован на 800GbE-решения, систем ИИ и машинного обучения, дата-центры гиперскейлеров и облака, HPC и квантовые вычисления. Отличительными чертами нового стандарта станут:

Публикация финальной версии спецификации запланирована на 2025 год. Ожидается, что программа для проверки соответствия стандарту PCIe 7.0 будет доступна в 2027 году, а продукты будут выпущены после этого.

17.11.2023 [21:46], Алексей Степин

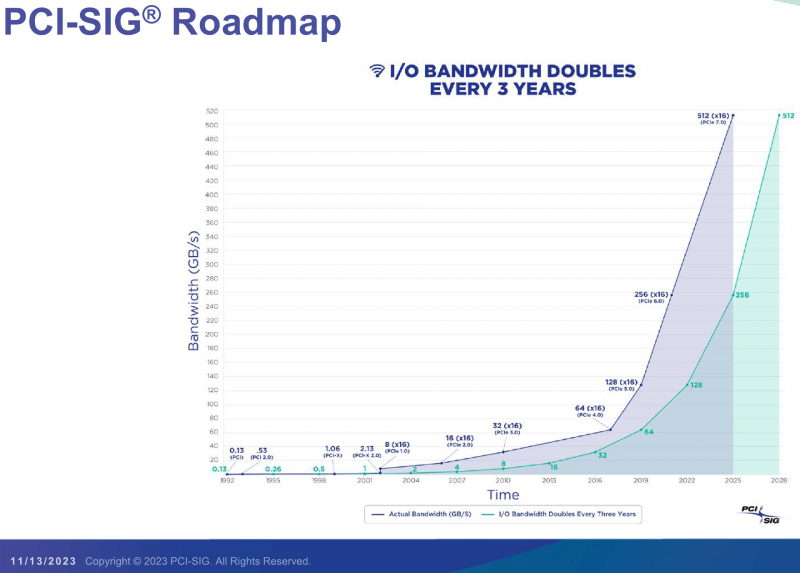

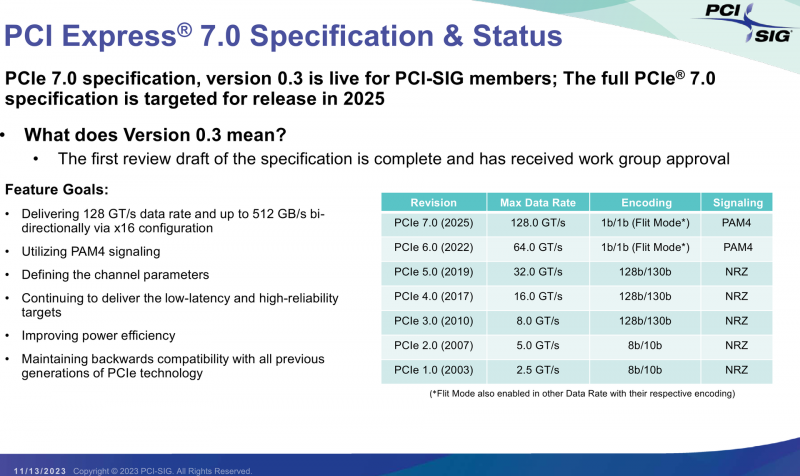

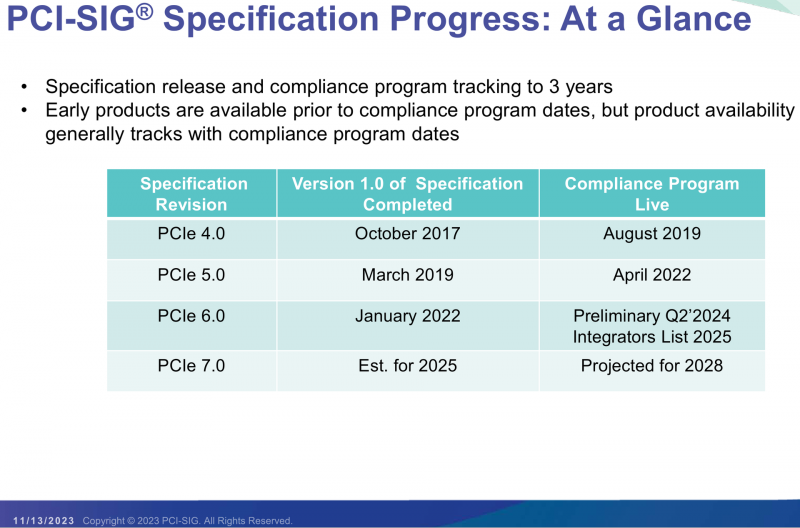

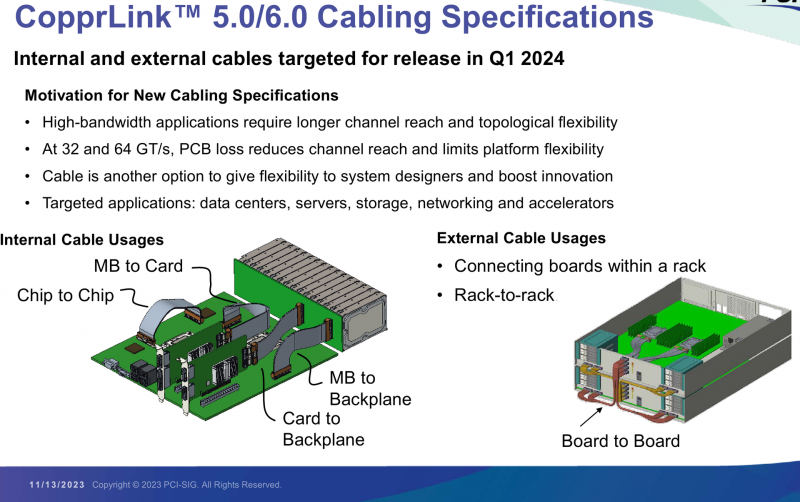

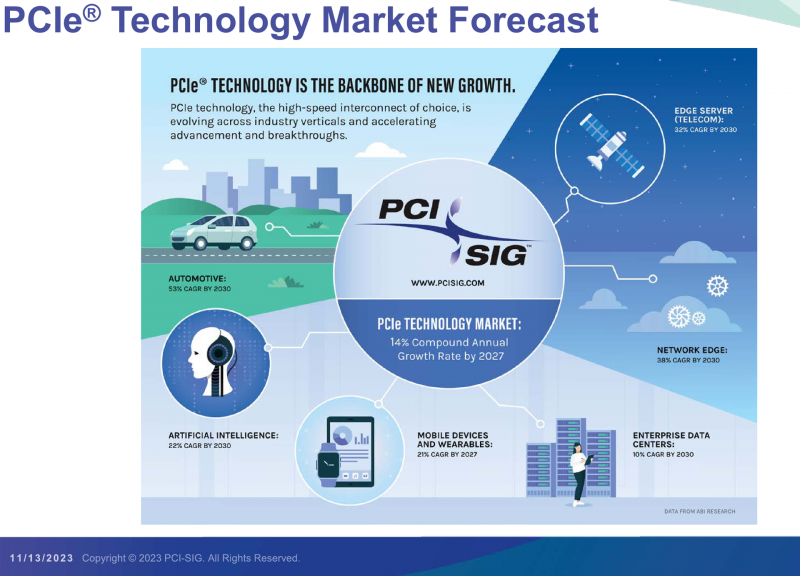

PCI-SIG выпустила предварительные спецификации PCIe 7.0 и анонсировала кабели CopprLinkОрганизация PCI Special Interest Group (PCI-SIG) рассказала о последних планах по развитию интерфейса PCI Express. В числе прочего были опубликованы сведения о новом стандарте кабелей и разъёмов CopprLink для подключений PCIe 5.0/6.0. Основанная в 1992 году организация PCI-SIG опубликовала первые спецификации PCI Express в 2003 году, а сегодня без этого интерфейса невозможно представить себе ни одну мало-мальски мощную вычислительную систему. В PCI-SIG на данный момент входит свыше 950 участников. Планы по развитию PCI Express, простирающиеся до 2028 года, показывают, что разработка новых, более производительных версий шины идёт темпами, позволяющими удовлетворить требования к скорости IO-подсистем, удваивающиеся примерно каждые 3 года. В версии PCIe 7.0 планируется довести этот показатель для x16-подключений до 512 Гбайт/с. Предварительная версия стандарта (релиз 0.3) была сформирована совсем недавно. На данный момент релиз спецификаций PCI Express 7.0 ожидается в 2025 году, а массовое появление новых продуктов на их основе запланировано на 2028 год. Впрочем, первые продукты наверняка появятся чуть раньше. Во II квартале 2024 года ожидается появление первых решений с PCIe 6.0, а массовый характер программа тестирования таких устройств на соответствие стандарту примет лишь в 2025. В августе этого года была сформирована новая рабочая группа PCI-SIG Optical Workgroup, ответственная за разработку оптического интерконнекта на базе PCI Express и взаимодействие с производителями в этой области. Задача заключается в адаптации стека технологий PCIe к оптической среде передачи данных с минимальными изменениями. Новые кабели позволят организовать соединения между стойками в пределах ЦОД в случаях, когда требуется минимальная латентность. Однако полная замена медных кабелей не планируется — оптика дополнит медь там, где нужна большая длина соединения. Поэтому PCI-SIG ведёт разработку нового стандарта электрических кабелей под общим названием CopprLink, который должен будет заменить существующие кабели OCuLink. Возможностей последних для организации внутрисистемного интерконнекта в современных условиях уже не всегда достаточно. Новые серверы и СХД требуют более высокой пропускной способности и гибкости топологии, что учитывается при разработке CopprLink. Эти кабели позволят как обеспечивать высокоскоростные подключения в пределах самих систем, так и соединять между собой шасси в пределах стойки. Разрабатываются и варианты для межстоечного соединения. Вопреки непроверенным слухам, CopprLink не поддерживает передачу сколько-нибудь мощного питания и не является заменой стандарту 12VHPWR. В настоящее время спецификации CopprLink, обеспечивающего работу на скоростях PCIe 5.0/6.0, уже достигли версии 0.9. Полноценный анонс технологии должен состояться в начале 2024 года. Технология PCI Express востребована во многих сегментах, от традиционных серверов и ПК до крупных ЦОД, телеком-платформ, ИИ-кластеров, умного транспорта и даже в мобильных и носимых устройствах. Ожидается, что в период до 2027 показатель CAGR для рынка PCIe-решений составит 14 %, а к концу периода он достинет объёма $10 млрд. Быстрее всего развитие будет идти в секторе автомобильных решений (CAGR 53 % до 2030 года), периферийных сетевых (38 %) и телекоммуникационных (32 %) платформ.

11.11.2023 [23:59], Алексей Степин

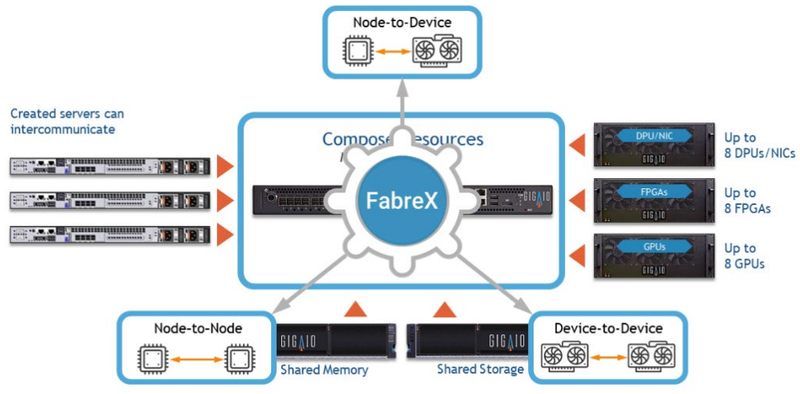

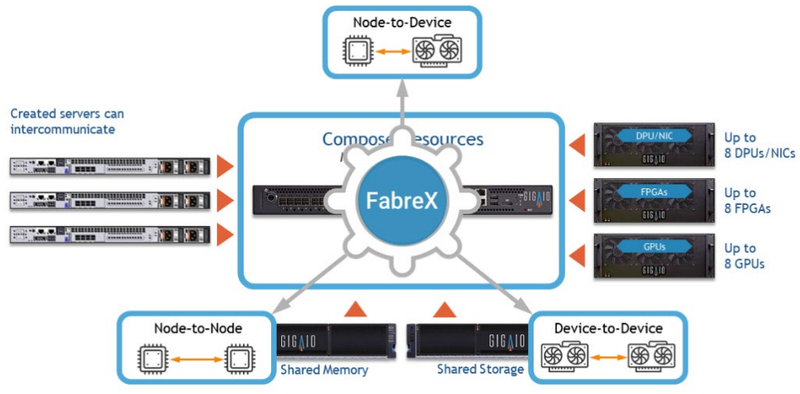

СуперДупер: GigaIO SuperDuperNODE позволяет объединить посредством PCIe сразу 64 ускорителяКомпания GigaIO, чьей главной разработкой является система распределённого интерконнекта на базе PCI Express под названием FabreX, поставила новый рекорд — в новой платформе разработчикам удалось удвоить количество одновременно подключаемых PCIe-устройств, увеличив его с 32 до 64. О разработках GigaIO мы рассказывали читателям неоднократно. Во многом они действительно уникальны, поскольку созданная компанией композитная инфраструктура позволяет подключать к одному или нескольким серверам существенно больше различных ускорителей, нежели это возможно в классическом варианте, но при этом сохраняет высокий уровень утилизации этих ускорителей.

GigaIO SuperNODE. Источник изображений здесь и далее: GigaIO В начале года компания уже демонстрировала систему с 16 ускорителями NVIDIA A100, а летом GigaIO представила мини-кластер SuperNODE. В различных конфигурациях система могла содержать 32 ускорителя AMD Instinct MI210 или 24 ускорителя NVIDIA A100, дополненных СХД ёмкостью 1 Пбайт. При этом система в силу особенностей FabreX не требовала какой-либо специфической настройки перед работой.

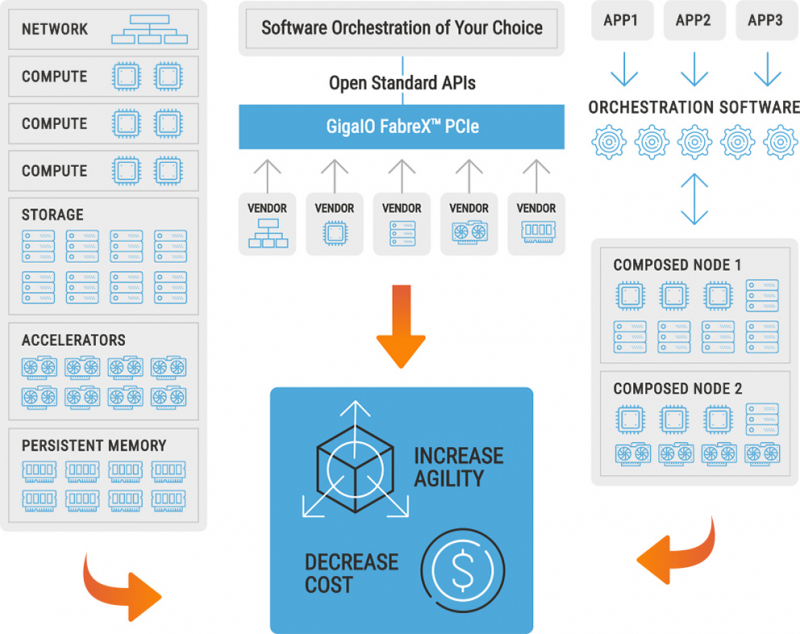

FabreX позволяет физически объединить все типы ресурсов на базе существующего стека технологий PCI Express На этой неделе GigaIO анонсировала новый вариант своей HPC-системы, получившей незамысловатое название SuperDuperNODE. В ней она смогла удвоить количество ускорителей с 32 до 64. Как и прежде, система предназначена, в первую очередь, для использования в сценариях генеративного ИИ, но также интересна она и с точки зрения ряда HPC-задач, в частности, вычислительной гидродинамики (CFD). Система SuperNODE смогла завершить самую сложную в мире CFD-симуляцию всего за 33 часа. В ней имитировался полёт 62-метрового авиалайнера Конкорд. Хотя протяжённость модели составляет всего 1 сек, она очень сложна, поскольку требуется обсчёт поведения 40 млрд ячеек объёмом 12,4 мм3 на протяжении 67268 временных отрезков. 29 часов у системы ушло на обсчёт полёта, и ещё 4 часа было затрачено на рендеринг 3000 4К-изображений. С учётом отличной масштабируемости при использовании SuperDuperNODE время расчёта удалось сократить практически вдвое. Как уже упоминалось, FabreX позволяет малой кровью наращивать число ускорителей и иных мощных PCIe-устройств на процессорный узел при практически идеальном масштабировании. Обновлённая платформа не подвела и в этот раз: в тесте HPL-MxP пиковый показатель утилизации составил 99,7 % от теоретического максимума, а в тестах HPL и HPCG — 95,2 % и 88 % соответственно. Компания-разработчик сообщает о том, что программное обеспечение FabreX обрело завершённый вид и без каких-либо проблем обеспечивает переключение режимов SuperNODE между Beast (система видна как один большой узел), Swarm (множество узлов для множества нагрузок) и Freestyle Mode (каждой нагрузке выделен свой узел с заданным количеством ускорителей). Начало поставок SuperDuperNODE запланировано на конец года. Партнёрами, как и в случае с SuperNODE, выступят Dell и Supermicro.

24.10.2023 [12:35], Сергей Карасёв

Консорциум PCI-SIG открыл тестовые лаборатории для технологии PCI ExpressКонсорциум PCI-SIG объявил об открытии авторизованных испытательных лабораторий (ATL) для тестирования технологий PCI Express (PCIe). Участники PCI-SIG смогут получить статус лаборатории, пройдя специальный квалификационный процесс. Прохождение тестирования на базе ATL позволит заинтересованным сторонам претендовать на включение в список интеграторов PCI-SIG Integrators List. Лаборатории обязаны обеспечивать возможность проведения необходимых тестовых измерений в соответствии с требованиями PCI-SIG. Первой авторизованной площадкой ATL стала Granite River Labs (GRL). Компания начала деятельность в 2010 году: она предоставляет услуги по тестированию, чтобы помочь разработчикам оборудования во внедрении технологий высокоскоростного подключения. GRL сотрудничает с более чем 500 компаниями-производителями полупроводников и различных систем, предоставляя комплексные инженерные услуги и решения для испытаний в своих центрах исследований и разработок по всему миру. Появление авторизованных тестовых лабораторий предоставляет разработчикам дополнительную возможность принять участие в программе соответствия PCI-SIG. При этом компании смогут выводить продукты с поддержкой PCIe на коммерческий рынок в соответствии со своим собственным графиком.

02.08.2023 [18:00], Сергей Карасёв

Светлое будущее: у PCIe появится версия с оптическими соединениями — создана рабочая группа для разработки технологииКонсорциум PCI-SIG объявил о формировании рабочей группы PCI-SIG Optical Workgroup, которая займётся реализацией интерфейса PCI Express (PCIe) по оптическим соединениям. Это, как ожидается, станет важным этапом развития соответствующей экосистемы. Внедрение оптических соединений для PCIe по сравнению с существующими решениями обеспечит более высокую пропускную способность, пониженное энергопотребление, увеличенную дальность действия и меньшие задержки.

Источник изображения: pixabay.com Новая технология, как ожидается, будет востребована в облачных дата-центрах, системах НРС и на площадках гиперскейлеров. Речь идёт о создании системы, поддерживающей широкий спектр оптических технологий. Консорциум PCI-SIG призывает всех своих участников присоединиться к Optical Workgroup, поделиться опытом и помочь определить конкретные цели рабочей группы и требования к аппаратным компонентам. Новая рабочая группа сосредоточит усилия над тем, чтобы сделать архитектуру PCIe более подходящей для оптических сетей. Между тем, как отмечается, продолжаются работы над спецификацией PCIe 7.0, которая предусматривает увеличение производительности до 128 ГТ/с по одной линии.

18.07.2023 [22:45], Сергей Карасёв

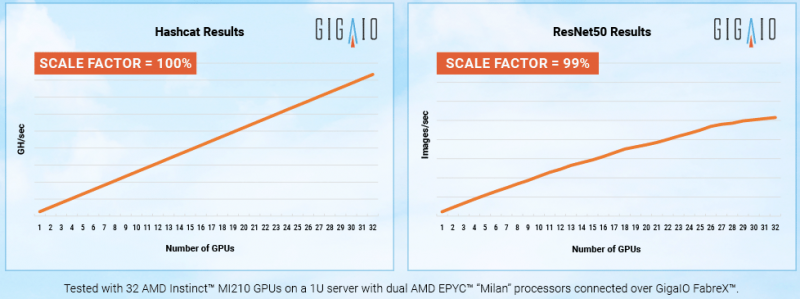

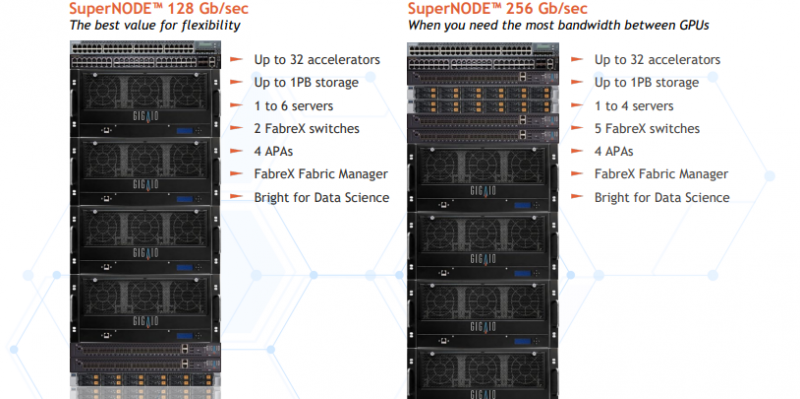

Суперкомпьютер в стойке: GigaIO SuperNODE позволяет объединить 32 ускорителя AMD Instinct MI210Компания GigaIO анонсировала HPC-систему SuperNODE, предназначенную для решения ресурсоёмких задач в области генеративного ИИ. SuperNODE позволяет связать воедино до 32 ускорителей посредством компонуемой платформы GigaIO FabreX. Архитектура FabreX на базе PCI Express, по словам создателей, намного лучше InfiniBand и NVIDIA NVLink по уровню задержки и позволяет объединять различные компоненты — GPU, FPGA, пулы памяти и пр. SuperNODE даёт возможность более эффективно использовать ресурсы, нежели в случае традиционного подхода с ускорителями в составе нескольких серверов. В частности для SuperNODE доступны конфигурации с 32 ускорителями AMD Instinct MI210 или 24 ускорителями NVIDIA A100 с хранилищем ёмкостью до 1 Пбайт. При этом платформа компактна, энергоэффективна (до 7 кВт) и не требует дополнительной настройки перед работой. Поскольку приложения с большими языковыми моделями требуют огромных вычислительных мощностей, технологии, которые сокращают количество необходимых обменов данными между узлом и ускорителем, имеют решающее значение для обеспечения необходимой скорости выполнения операций при снижении общих затрат на формирование инфраструктуры. Что немаловажно, платформ, по словам разработчиков, демонстрирует хорошую масштабируемость производительности при увеличении числа ускорителей. «Система SuperNODE, созданная GigaIO и работающая на ускорителях AMD Instinct, обеспечивает привлекательную совокупную стоимость владения как для традиционных рабочих нагрузок HPC, так и для задач генеративного ИИ», — сказал Эндрю Дикманн (Andrew Dieckmann), корпоративный вице-президент и генеральный менеджер по дата-центрам AMD. Стоит отметить, что у AMD нет прямого аналога NVIDIA NVLink, так что для объединение ускорителей в большие пулы с высокой скоростью подключения возможно как раз с использованием SuperNODE.

25.01.2023 [18:30], Алексей Степин

GigaIO FabreX обещает удвоить эффективность использования ресурсов ускорителей для платформ на базе Sapphire RapidsКомпания GigaIO, разработчик компонуемой платформы FabreX также поддержала выпуск новых процессоров Intel Xeon. Сертифицированная платформа GigaIO GigaPod на базе Sapphire Rapids показала возросший на 106 % уровень утилизации ускорителей в сравнении с платформой NVIDIA DGX, использующей InfiniBand.

Коммутатор FabreX. Источник здесь и далее: GigaIO Конфигурация тестовой системы включала в себя сервер на базе Sapphire Rapids, к которому с помощью FarbeX были подключены 16 ускорителей NVIDIA A100. Как показало тестирование, такая конфигурация куда эффективнее использует ресурсы, нежели в случае традиционного подхода, когда ускорители «раскиданы» по нескольким серверам и коммуникация между ними осуществляется посредством высокоуровневой сети вроде InfiniBand.

Интерконнект GigaIO FabreX универсален и поддерживает подключение любых типов устройств в рамках платформы GigaPod Глава GigaIO отметил, что в классическом варианте уровень загрузки ускорителей может опускаться до 15 %, и это при том, что стоимость мощных ускорителей иногда составляет до 80 % стоимости всей системы. Финальный выигрыш в стоимости GigaPod в версии с процессорами Sapphire Rapids может достигать 30 % в пользу решения GigaIO. Компонуемая архитектура, продвигаемая GigaIO, существенно эффективнее традиционных: в её основе лежит PCI Express, что гарантирует задержку на уровне менее 1 мкс. По этому показателю FabreX превосходит и InfiniBand, и NVIDIA NVLink. При этом полностью поддерживается DMA.

Программная архитектура FabreX Платформа FabreX универсальна, она позволяет подключать к системе практически любые компоненты, от GPU до пулов памяти и FPGA, в том числе с CXL. Ещё на SC20 компания продемонстрировала 5U-шасси, вмещающие до 10 ускорителей с интерфейсом PCIe 4.0. Архитектура GigaIO является программно-определяемой и совместима с большей частью современного ПО для управления и распределения нагрузки, в ней реализован набор открытых API Redfish.

16.10.2022 [00:19], Сергей Карасёв

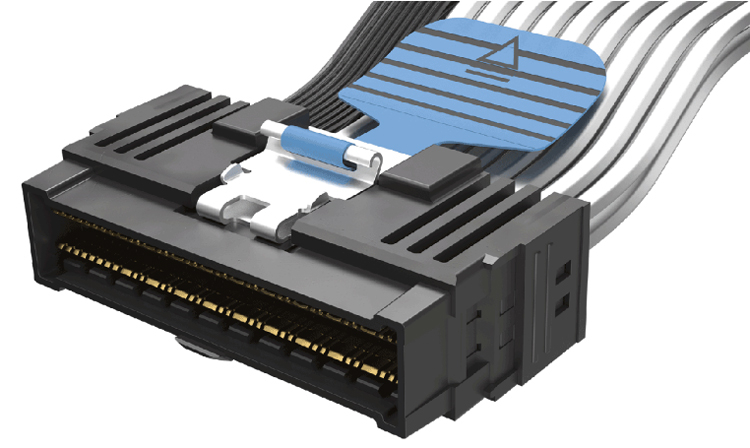

Molex представила кабельную систему NearStack PCIe для OCP-серверов следующего поколенияКомпания Molex анонсировала кабельную систему NearStack PCIe, которая будет применяться в серверном оборудовании нового поколения. В разработке приняли участие члены Open Compute Project (OCP). NearStack PCIe использует архитектуру Direct-To-Contact и предусматривает полностью автоматизированный процесс изготовления кабелей. По словам Molex, данная технология повышает эффективность производства, способствует улучшению точности передачи сигналов, сокращению потерь и уменьшению задержек. В то же время механический дизайн NearStack PCIe помогает оптимально использовать имеющееся пространство, упростить интеграцию, повысить надёжность подключения и минимизировать физические конфликты с соседними компонентами.

Источник изображений: Molex Для коннекторов NearStack PCIe (27,2 × от 11,2 × от 9,55 мм) предусмотрено несколько вариантов исполнения, в частности, с «язычком» для быстрого отсоединения или с защёлкой, а также с шлейфом, расположенным под углом 0°, 60° или 90°. Также возможно применение гибридных кабелей с разъёмом NearStack PCIe только на одном конце, что позволяет воспользоваться технологией без перепроектирования или замены имеющегося оборудования.  NearStack PCIe утверждён комитетом Small Form Factor (SFF) в качестве стандарта SFF-TA-1026, а OCP рекомендует её для серверов эталонного дизайна. Кроме того, решение NearStack PCIe включено в спецификации OCP Modular Extensible I/O (M-XIO) и Full Width HPM Form Factor (M-FLW) в качестве составляющей нового семейства платформ OCP Data Center Modular Hardware Systems (DC-MHS). Технология доступна для лицензирования поставщикам оборудования, среди которых уже есть как минимум ещё один изготовитель NearStack PCIe помимо самой Molex. |

|